Eine Applikation oder eine Website, die steht, kann zum Alptraum werden. Wenn Kunden im Webshop nicht einkaufen oder auf der Handelsplattform nicht traden können, wird der Schaden je nach der Größe des Anbieters schnell sehr groß. Dazu kommen die damit verbundenen Reputations- und Vertrauensverluste.

Doch die Ursachen für Fehler zu finden, wird durch die gegenwärtig dominanten Technologien nicht gerade vereinfacht. Dazu trägt nicht nur das an sich schon immer weiter wachsende Daten- und Traffic-Volumen bei. Anwendungslandschaften bestehen heute aus vielfältigen Schichten, die mittlerweile auch noch teils innerhalb und teils außerhalb der Firmengrenzen liegen können.

Deren Interaktionen durchschauen selbst Spezialisten nicht immer bis ins letzte Detail. Während früher den meisten Applikationen ein bestimmter Port zur Verfügung stand, laufen heute immer mehr Prozesse über http auf dem Bildschirm ein, und damit über denselben Port. Die einzelnen Datenströme sind also am Port an sich nicht mehr unterscheidbar. Das trägt dazu bei, dass guter Rat im Fall von Ausfällen häufig im wahrsten Sinne des Wortes teuer ist.

Allerdings bemühen sich die Hersteller, zügig Lösungen und Konzepte für die durch den technologischen Fortschritt neu entstandenen Herausforderungen zu finden. Derzeit entstehen Monitoring-Tools, die auf die Verarbeitung zahlreicher applikationsbezogener Datenströme und sehr unterschiedlicher Messaufgaben zugeschnitten sind.

Ein Beispiel ist Compuware mit APM. Das Werkzeug zum anwendungsorientierten Netzleistungs-Monitoring wird auf Applikations- oder Webservern installiert und kann jede Transaktion vom Client bis auf die hinter einer Applikation liegenden Datenbanken verfolgen.

“Wir können damit zum Beispiel ermitteln, warum Datenbanken ohne erkennbaren Grund abstürzen oder Applikationen immer an derselben Stelle aussteigen, obwohl es dafür auf den ersten Blick keinen Grund gibt”, sagt Heiko Specht, Accout Manager bei Compuware.

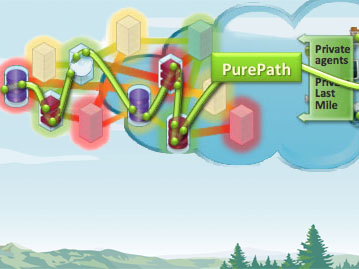

Konkurrenten, die ähnliche Lösungen entwickeln oder anbieten, sind beispielsweise Riverbed Cascade, Produkte von CA oder Opnet. Denen habe man aber voraus, erklärt Specht, dass Compuware-APM tatsächlich mit den Technologien PurePath und PureStack jeden einzelnen Besuch eines Anwenders auf einer Website separat analysieren könne.

Oft aber beginnen die Schwierigkeiten beim Abfragen einer Applikation nicht irgendwo zwischen Client und Rechenzentrum, sondern im Rechenzentrum selbst, wo die Datenströme durch breitbandige Multikanal-Verbindungen und über sie wandernde Applikationsdaten oder ganze virtuelle Maschinen ebenfalls größer werden.

Gleichzeitig verwenden Administratoren immer mehr Spezialwerkzeuge, um den Datenverkehr darzustellen und gezielt bestimmte Fragen zur Netzwerk- oder Applikationsleistung zu beantworten. Meist spiegelt man dafür Ports oder ganze Switches und spielt die gespiegelten Daten dann den vorhandenen Tools zu. Weil die Werkzeuge teils sehr spezielle Aufgaben haben, muss jedes von ihnen normalerweise viel zu viele Daten beackern, die für die eigentlich zu lösende Aufgabe gar keinen Nutzen bringen.

Ein Ansatz dafür, dieses Problem zu lösen, ist der Aufbau eines speziellen Filternetzwerks, das die Daten, die an verschiedenen Stellen im Netz gesammelt werden, mit vom Anwender zuvor definierten Filtern vorsortiert. Dabei werden sie so aufbereitet, dass sie genau zu der Analyseaufgabe des jeweiligen Werkzeugs passen, unabhängig davon, wo sie entstehen. Diesen Weg geht etwa Gigamon mit dem hochskalierbaren Visibility Netzwerk, das nahezu unbegrenzt durch neue Knoten erweiterbar ist. Auch derTraffic-Monitoring-Switch CVU von cPacket verfolgt diesen Ansatz und filtert Daten Tool-spezifisch vor.

Enterasys, bekannt besonders für eine proprietäre Flow-basierende Technologie, beschäftigt sich derzeit damit, wie man die Unmengen applikationsbezogener Datenströme, die in softwaredefinierten Netzwerken auftreten – das Unternehmen spricht hier von sechsstelligen Zahlen – in Echtzeit ohne zusätzliche Agenten an einer beliebigen Stelle des Netzes analysieren kann.

Der Hersteller plant dafür eine Art Aufsatz zu dem flow-basierenden ASIC, der den Kern der Switch-Produkte von Enterasys bildet. Die Technologie, die in Echtzeit so ziemlich jede Applikation erkennen und damit deren Leistung auch messen können soll, ist zum Patent angemeldet und wird dem Markt im Herbst vorgestellt.

Einen interessanten Weg geht die US-amerikanische NetDialog. Zu den Anwendern der NetDialog-Lösung NetX– zählen wichtige TK-Provider. Das Unternehmen zieht aus Daten, die aus den Datenströmen an Ein- und Ausgangspots verschiedener Netzgeräte in Cloud- oder WAN-Verbindungen gewonnen wurden, Rückschlüsse auf die Anwendungsperformance und wandelt diese dann mit Hilfe von Business-Intelligence-Mechanismen in Dollarwerte um. Die Auswertungen erfolgen dabei in der NetX-Cloud, auf die die Kunden übers Web zugreifen. Mit dieser Lösung lässt sich zum Beispiel entscheiden, welche IT-Optimierungen wirtschaftlich am meisten bringen oder wie viel ein Ausfall einer Verbindung tatsächlich kostet – in Zeiten knapper IT-Budgets sicher eine der interessantesten Fragen.

Politik, Wirtschaft und Privatpersonen müssen gemeinsam handeln, um Schutzmechanismen zu entwickeln – ohne das innovative…

Geringere Nachfrage nach Cybersicherheitsfachleuten und Fokussierung auf technische als auch organisatorische Fähigkeiten liegen angesichts der…

Die Abhängigkeit von Drittanbietern erhöht das Risiko erheblich, denn jede Station in der Lieferkette kann…

Laut einer Studie von Bitkom und Hartmannbund haben 15 Prozent der hiesigen Praxen mindestens eine…

Fraunhofer-Forschende wollen die Wertschöpfungskette von Rohstoffen transparenter machen. Ziel ist eine bessere Kreislaufwirtschaft.

Lünendonk-Studie: 54 Prozent der befragten Verwaltungen wollen den Cloud-Anteil ihrer Anwendungen bis 2028 auf 40…