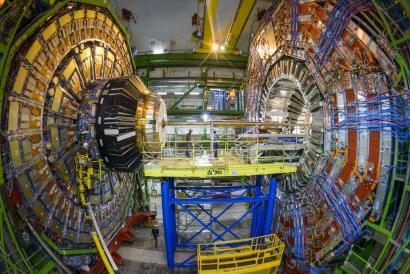

ATLAS am CERN. Die Open Telekom Cloud soll die Ressourcen des Forschungsneztes erweitern. (Bild: CERN)

Am CERN, der europäische Organisation für Kernforschung, sollen in den nächsten drei Monaten 1000 parallele virtuelle Maschinen die in dem Forschungszentrum generierten Daten verarbeiten. Über verbundene Cluster-Speicher stellt die Telekom über den auf der CeBIT frisch vorgestellten Service zudem über 500 TB Speicher bereit. T-Systems stellt zudem mindestens 10 Gbit/s Bandbreite sowie die Möglichkeit des Anschlusses an deutsche und europäische Forschungsnetze bereit.

Das Projekt baut auf der Helix Nebula-Initiative auf. Unternehmen wie Atos, CloudSigma, Cloudeo, T-Systems und Forschungseinrichtungen wie ESA, DESY oder CERN entwickeln dabei Grundlagen für Standardschnittstellen, SLAs, Konnektivität oder auch Beschaffungsmethoden im Wissenschaftsumfeld.

Der Testlauf solle zeigen, ob die Verarbeitung von wissenschaftlichen Daten auch über die Cloud-Services eines Standardanbieters abgebildet werden kann. Dafür wird das Projekt mit einer Benchmarkstudie begleitet. Dabei sollen vor allem Inbetriebnahme, Leistungsfähigkeit und das Reporting der Infrastruktur getestet werden. Zur Akzeptanzförderung und Stärkung des Vertrauens in Cloud-Angebote in Europa sollen die Ergebnisse der Zusammenarbeit veröffentlicht werden.

Das Genfer CERN ist einer der frühsten Nutzer der Cloud-Technologie OpenStack. Nun bekommen die Forscher neben einer nutzerfreundlichen Oberfläche auch verschieden OpenStack-APIs bereitgestellt. Damit lassen sich die Services auf die Bedürfnisse der Forscher anpassen.

Dem CERN stehen für die Lösung eine benutzerfreundliche Oberfläche sowie OpenStack-APIs zur Verfügung, so dass maximale Kundenanpassung und Flexibilität gewährleistet sind. Das Kernforschungsinstitut wird das Projekt mit einer Benchmarkstudie zu Inbetriebnahme, Leistung und Reporting begleiten.

Mit dem Projekt will die Telekom dynamische Cloud-Services entwickeln, in denen öffentliche und kommerzielle E-Infrastrukturen kombiniert werden. Die zusammen mit dem CERN angestrebte Lösung unterliege den europäischen Vorschriften für Datenschutz- und Datenverarbeitung. Ziel ist es, die Forschung über Cloud-Infrastrukturen zu beschleunigen. Am Ende soll eine von der EU geförderte inderdisiziplinäre Wissenschaftscloud stehen.

“Wir freuen uns über die Zusammenarbeit mit T-Systems. Wir möchten Erfahrungen sammeln, wie wir kommerzielle Cloud-Dienste noch besser praktisch in unsere physikalischen Abläufe einfügen und weitere Ressourcen in unsere private cloud integrieren können”, kommentiert Helge Meinhard, Mitarbeiter der IT am CERN.

In erster Linie geht es um die Verarbeitung von Daten aus dem Large Hadron Collider am CERN und um die beiden Experimente ATLAS und CMS über die Daten über die Kollisionen von Protonen gesammelt werden, um damit die letzten Geheimnisse des Universums zu entschlüsseln. Derzeit werden diese Daten in einem großen verteilten System, dem ATLAS Distributed Computing Environment (ADC) verarbeitet, wie es in einer Mitteilung von Helix Nebula heißt http://www.helix-nebula.eu/usecases/cern-lhc-use-case . Und dieses System soll zusammen mit einer Analytics-Lösung nun auch in die Cloud ausgelagert werden.

Ferroelektrisches Oxid verringert den Energieverbrauch erheblich und verkürzt Latenzzeiten von Computerarchitekturen.

Hyperscaler ermöglichen ISVs eine schnellere Markteinführung ihrer Produkte, wobei damit die verbundenen Herausforderungen steigen, sagt…

Warenhauskette setzt auf die KI-gesteuerten Fähigkeiten zur Bedarfsplanung und Nachversorgung von Blue Yonder.

Technische Hochschule Augsburg (THA) will Hersteller auf die neue EU-Verordnung hinweisen, die Cybersicherheit für vernetzte…

Mit der steigenden Anzahl von Endpunkten, wächst die Komplexität, die mit dem Unternehmensnetzwerken verbundenen Geräte…

Die Kombination aus Blockieren und fundierter Analyse bietet eine resiliente Sicherheitsarchitektur, sagt Andrea Napoli von…