FakeCatcher: Intel erkennt Deepfakes in Echtzeit

FakeCatcher erreicht eine Erkennungsrate von 96 Prozent. Die neue Technik erkennt und analysiert den Blutfluss in menschlichen Gesichtern.

Intel hat im Rahmen seiner Bemühungen für einen Verantwortungsvollen Einsatz von künstlicher Intelligenz eine neue Technik namens FakeCatcher entwickelt. Sie soll in der Lage sein, sogenannte Deepfakes in Echtzeit zu erkennen. Nach Angaben des Unternehmens liegt die Erfolgsquote bei 96 Prozent.

Der Chiphersteller reagiert damit auf die zunehmende Verbreitung von Deepfake-Videos unter anderem von Prominenten, die von echten Videos kaum zu unterscheiden sind. “Deepfake-Videos gibt es mittlerweile überall. Sie haben sie wahrscheinlich schon gesehen: Videos von Prominenten, die Dinge tun oder sagen, die sie nie getan haben”, sagte Ilke Demir, Senior Staff Reseach Scientist bei Intel.

Entwickelt wurde FakeCatcher von Demir in Zusammenarbeit mit Umur Ciftci von der State University of New York. Basierend auf Software und Hardware von Intel erfolgt die Bedienung über ein Web-Interface. Unter anderem kamen bei der Entwicklung Tools wie OpenVino für AI-Modelle für Gesichtserkennung und das Toolkit OpenCV zum Einsatz, das Bilder und Videos in Echtzeit verarbeitet. Durch den Einsatz von Xeon-Scalable-Prozessoren von Intel soll es möglich sein, bis zu 72 unterschiedliche Erkennungs-Streams gleichzeitig in Echtzeit auszuführen.

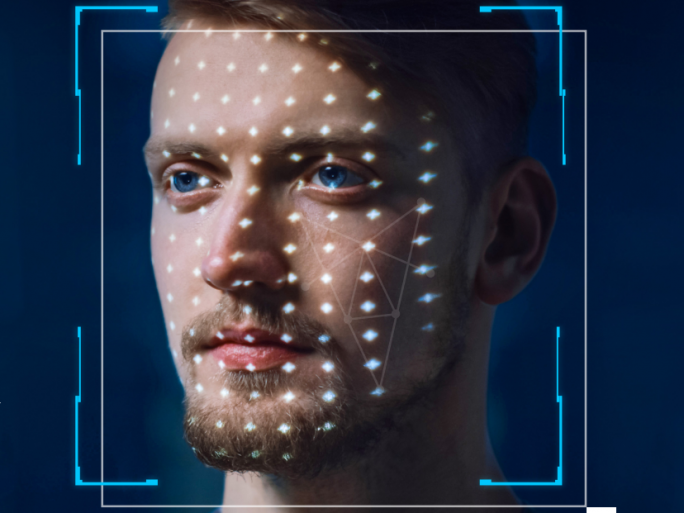

Laut Intel verfolgt FakeCatcher einen neuen Ansatz, um Deepfakes zu erkennen. Statt sich auf die Analyse der Rohdaten eines Videos zu beschränken, versucht FakeCatcher menschliche Details zu erkennen. Konkret wird der Blutfluss in den Pixel eines Videos erfasst. “Diese Blutflusssignale werden aus dem gesamten Gesicht gesammelt, und Algorithmen übersetzen diese Signale in räumlich-zeitliche Karten. Mithilfe von Deep Learning können wir dann sofort erkennen, ob ein Video echt oder gefälscht ist”, teilte Intel mit.

Als mögliche Einsatzgebiete der Technik nannte Intel Social-Media-Plattformen. Sie könnten so in Echtzeit verhindern, dass Nutzer gefährliche Deepfakes-Videos veröffentlichen. Nachrichtenagenturen seien zudem in der Lage, manipulierte Videos zu erkennen und deren Weiterverbreitung zu stoppen.