Viele Unternehmen sehen sich Problemen gegenüber, weil ihre IT-Prozesse zu langsam und ihre Kernanwendungen zu schwer veränderlich sind. Denn die Idealvorstellung ist heute, sich jederzeit schnellstmöglich allen Trends am Markt anpassen zu können – seien dies modifizierte Kundenwünsche, neue, häufig digitale Produkte oder Services, ein anderes Wettbewerbsumfeld, eine neue Unternehmensstruktur oder irgend etwas anderes. Dass

Viele Unternehmen sehen sich Problemen gegenüber, weil ihre IT-Prozesse zu langsam und ihre Kernanwendungen zu schwer veränderlich sind. Denn die Idealvorstellung ist heute, sich jederzeit schnellstmöglich allen Trends am Markt anpassen zu können – seien dies modifizierte Kundenwünsche, neue, häufig digitale Produkte oder Services, ein anderes Wettbewerbsumfeld, eine neue Unternehmensstruktur oder irgend etwas anderes.

Dass es so schwer ist, die IT zu flexibilisieren, hat mehrere Gründe. Einer der wichtigsten ist die siloartige Struktur der klassischen IT mit ihren wenig durchlässigen Infrastrukturkomponenten Server, Storage und Netzwerke. Sie sind gekoppelt mit einem entsprechenden Personalaufbau in Infrastrukturteams, mit IT-Prozessen, die ebenfalls die großen Komponenten der IT nachzeichnen und häufig sehr langwierig sind, und mit Budgets. Abschreibungsrichtlinien und Wartungsverträge tragen oft genug dazu bei, die Flexibilisierung zu erschweren.

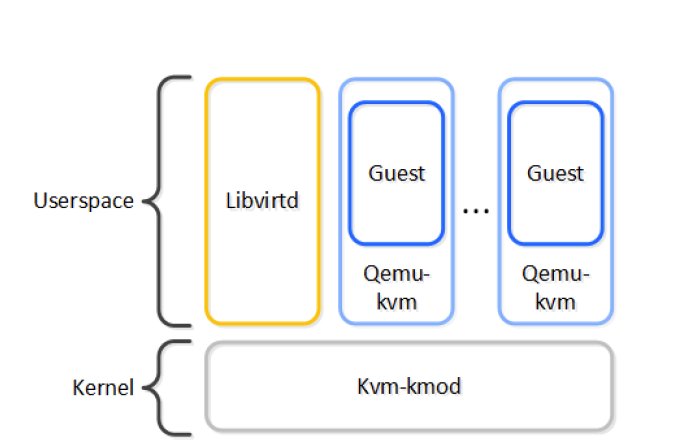

Zudem ist die Auslastung der Hardware teils sehr gering. Klassische Virtualisierung hat dies durchbrochen, allerdings nicht zu durchschlagenden Erfolgen geführt. Vereinfacht wurde die Infrastruktur kaum. Vielmehr kamen eine oder mehrere zusätzliche Softwareschichten und damit eine weitere Komplexitätsebene hinzu.

Auch die Cloud mit ihren ganz eigenen Protokollstrukturen trägt als solches nicht zur Vereinfachung der Unternehmens-IT bei, sondern fügt ihr, wie sich in immer mehr Unternehmen zeigt, nun wiederum eine Infrastrukturebene hinzu. Zwar verspricht Cloud-Nutzung, umfangreiche Investitions-, Wartungs- und Supportkosten für IT im eigenen Haus schnellstmöglich in ausschließlich nutzungsbasierte Kosten umzuwandeln. Allerdings stellt sich bei vielen Unternehmen allmählich heraus, dass die erhofften Kostenvorteile sich nur zum Teil oder gar nicht realisieren und zudem nicht einkalkulierte Kosten auftauchen, beispielsweise weil die Übersicht über die Cloud-Infrastruktur fehlt oder Gebühren für das Herunterladen von Daten von der Cloud erstaunlich hoch sind.

Cloud und Container passen kaum zu vielen Altanwendungen

Auf der Anwendungsseite korrespondiert die Cloud-Infrastruktur immer öfter mit Containern und zumindest teilweise wieder verwertbaren Mikroservices, Anwendungs-Schnipseln, die einzelne Funktionen oder Funktionsbündel realisieren und idealtypisch über offene Schnittstellen miteinander in immer neuen Konstellationen verbunden werden können. Allerdings sieht das Originalkonzept für Docker-Container, die derzeit verbreitetste Container-Technologie genauso wenig persistente Storage vor wie Kubernetes, das derzeit verbreitetste Orchestrierungswerkzeug für Docker-Container. Persistenz und damit eine unverzichtbare Voraussetzung dafür, dass Business-Anwendungen wie Datenbanken, die persistente Daten brauchen auf einer Infrastruktur laufen können, muss durch Software-Plugins, zusätzliche Applikationen oder Ähnliches erst geschaffen werden.

Außerdem lassen sich viele Anwendungen, deren Code über Jahre und Jahrzehnte gewachsen ist, schlicht nicht einfach so in Mikroservices zerhacken. Oft versteht ja kaum noch jemand, wie dort was mit was zusammenhängt. Deshalb gibt es für Projekte, deren Ziel es ist, Altanwendungen in Mikroservices aufzuteilen und damit gangbar für eine Container-basierte Infrastruktur zu machen, keinerlei Erfolgsgarantie – tatsächlich entwickelten sich diese Angänge oft genug zu mit vielen Hoffnungen befrachteten, letztlich aber nur kostspieligen Fehlschlägen.

Hybride „IT der zwei Geschwindigkeiten“ als Behelf

Das führt in der Konsequenz bei immer mehr Unternehmen zur hybriden IT. Hier stehen auf der einen Seite „alte“ Infrastruktur mit Anwendungen, die auf virtuellen Maschinen laufen oder aber einen eigenen Server brauchen, auf der anderen die Cloud, in der neue, sogenannte Cloud-native Anwendungen meist nach DevOps-Prinzipien entwickelt und ausprobiert werden. Sie laufen vielleicht überhaupt nie On-Premises, vielleicht werden sie aber auch später auf die On-Premises-Infrastruktur portiert, wenn sie eine gewisse Reife und Stabilität erreicht haben.

Dabei ist es alles andere als einfach, beide Infrastrukturwelten sinnvoll zu verbinden, und meist geschieht dies auch nur lückenhaft oder für einige wenige Public Clouds. Das verwundert nicht: Haben sich doch die Cloud-Welt, die aus dem Reich der riesigen Internetgiganten wie AWS, Google oder Facebook stammt, und die On-Premises-Infrastrukturen getrennt voneinander entwickelt und müssen erst jetzt zusammenwachsen, weil Anwender sich nun einmal nicht befehlen lassen, auf welcher Art von Infrastruktur ihre Anwendungen laufen sollen. Die finanziellen Versprechen der Cloud werden aus ihrer Perspektive durch mangelnde Sicherheit mehr als kompensiert, gesetzliche Vorgaben zur Datenhaltung tun das Ihrige – auf absehbare Zeit werden viele Applikationen und Daten wohl kaum in der Cloud landen.

In der Konsequenz bedeutet das: Die erhofften Kostensenkungen durch Cloud bleiben ein schöner Traum, stattdessen steigt die Komplexität der Infrastruktur weiter. Und der nächste Komplexitätsschritt deutet sich bereits an: Multicloud heißt das Ziel, denn längst hat sich herausgestellt, dass die zu feste Bindung an einen einzigen Cloud-Provider das Unternehmen in ähnlich kostspielige Abhängigkeiten verstricken kann wie zuvor die Bindung an einen einzigen Hardwarelieferanten. Doch erst sehr allmählich erscheinen auf dem Markt Lösungen und Ansätze, die tatsächlich gestatten, den Überblick über alle in der Cloud befindlichen Ressourcen jederzeit zu behalten und Lasten, wenn sich woanders günstigere Möglichkeiten bieten, ohne viel Aufhebens dorthin zu verschieben.

Hyperkonvergenz als reiner On-Premises-Ansatz greift zu kurz

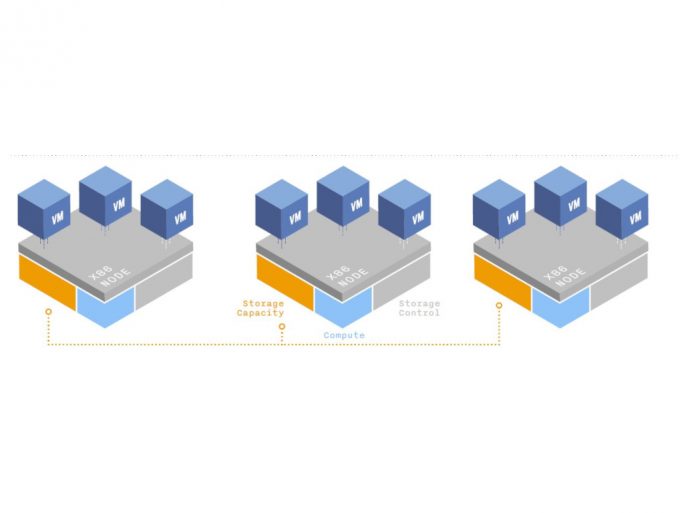

Immerhin versuchen seit einigen Jahren die Anbieter Cloud-ähnlich funktionierende, zunehmend rein Software-basierende Lösungen zu entwickeln, die die Architektur getrennter Infrastrukturtürme endgültig überwinden und durch ein von Anfang an integriert gedachtes, flexibel skalierendes System ersetzen, bei dem Scale-out oder Scale-up keine Probleme mehr machen. Bei diesen hyperkonvergenten Lösungen werden Server, Storage und Netzwerktechnologie in den Knoten per Software zu einer durchgängig verwaltbaren Ressource vereinigt. Diese Knoten bilden die Basis der Infrastruktur.

Idealerweise ist eine solche Lösung von der Hardware vollständig unabhängig, so lange diese einige grundlegende Anforderungen an die Leistungsfähigkeit unterstützt. Eine softwarebasierte HCI-Lösung sollte Virtualisierung als Grundtechnologie umfassen, dabei bestehende Hypervisoren und damit virtualisierte Infrastrukturen genauso unterstützen wie Cloud und Container sowie sogar Bare Metal, damit Anwender wirklich flexibel entscheiden können, wo sie eine Workload bereitstellen. Diese Flexibilität ist nur bei wenigen Anbietern vorhanden. Dabei ist entscheidend, dass auch Cloud-typische Standard-Schnittstellen wie die RESTful API von Anfang an tief in die Infrastruktur integriert sind und nicht nachträglich „angeflanscht“ wurden. Das sind Eigenschaften, wie sie eigentlich nur von vornherein Cloud-native entwickelte Produkte besitzen.

Von besonderer Bedeutung sind einfache Nutzbarkeit und weitgehende Automatisierung von Routineaufgaben, denn bei klassischen IT-Architekturen verbringen Administratoren unbestritten weit über die Hälfte ihrer Arbeitszeit mit Alltagsarbeit, die nur dazu dient, den Betrieb und die Sicherheit aufrecht zu erhalten. Zu einer fortschrittlichen HCI-Plattform gehören deshalb selbstverständlich professionelle Sicherheitsfeatures wie Backup, Disaster Recovery, Verschlüsselungsmöglichkeit und so weiter.

Die Benutzerschnittstelle und die Funktionen sollten aus dem Kontext heraus verständlich und bedienbar sein, ohne viel Seiten lange Handbücher und Erklärungen zu verlangen. Dasselbe gilt auch für Infrastrukturerweiterungen: Statt monatelanger Antrags- und Implementierungsprozeduren erwarten Anwender von HCI-Vendoren den Aufbau und die Einsatzbereitschaft neuer Ressourcen innerhalb weniger Stunden oder höchstens Tage. Eine einfache Benutzerschnittstelle ermöglicht auch Selbstbedienungsfunktionen für Anwender, die die IT-Verantwortlichen weiter entlasten und Kapazitäten frei machen für die Durchführung wertsteigernder und das Kerngeschäft wirksam unterstützender Initiativen.

Natürlich ist auch die Cloud-Integration eine unverzichtbare Funktion eines solchen Produkts. Dabei sollte die Technologie Anwender nicht auf eine bestimmte Cloud festlegen, sondern offen sein für flexible Integrationen mit allen möglichen Clouds. Nur so können Anwender tatsächlich Anwendungen zwischen Cloud- und sonstigen IT-Umgebungen On- oder Off-Premises nach Wunsch und ad hoc migrieren.

Freie Infrastrukturwahl für die Kunden

Dass eine Anwendung bisher auf einer virtuellen Maschine unter einem anderen Hypervisor als dem der Virtualisierungslösung lief, sollte beim Umstieg auf eine solche HCI-Lösung kein Problem darstellen: Am besten reicht ein Knopfdruck, schon ist die Applikation in das entsprechende Umfeld übertragen. Das ist allerdings nur bei wenigen Produkten so – meist ist die Anwendungsmigration langwierig, fehleranfällig und arbeitsintensiv.

Das beschriebene Konzept besticht, das zeigen die steil ansteigenden Absatzzahlen im Marktsegment Hyperkonvergente Infrastrukturen. So wuchs der weltweite Markt für HCI-Software zwischen dem vierten Quartal 2016 und dem vierten Quartal 2017 laut ICD um 69,4 Prozent auf mittlerweile über 1,2 Milliarden Dollar.

Anwender, die nach einer HCI suchen, sollten darauf achten, dass es sich bei den angebotenen Produkten tatsächlich um für professionelle Zwecke geeignete HCI handelt und nicht um mühselig zusammengestrickte Infrastukturkomponenten ohne tatsächlich tiefgehende Integration. Für professionelle Anwender spielt auch die Erfahrung des Anbieters eine Rolle: Oft können Newcomer, die immer wieder am HCI-Markt auftauchen, nicht für das Vorhandensein aller für Enterprise-Kunden notwendigen Funktionen verweisen. Wird ein HCI-Produkt andererseits großen Anbietern konventioneller Infrastruktur angeboten oder ein entsprechender Anbieter aufgekauft, ist sein weiteres Schicksal ungewiss, denn meist müssen derartige Anbieter Produkte aus ihrem bestehenden Portfolio kannibalisieren, um dem HCI-Produkt in ihrem Kundenkreis zu durchschlagendem Erfolg zu verhelfen.

Sind alle wichtigen Voraussetzungen seitens der HCI-Lösung gegeben, können Anwender damit tatsächlich ihre Infrastruktur auf die nächste Stufe heben: Sie können sich von den bisherigen heterogenen Infrastruktur- und Protokolltürmen unabhängig machen, ohne gleichzeitig von einem Cloud-Provider abhängig zu werden. Dadurch gewinnen sie die Flexibilität, die sie brauchen, um im globalen Wettbewerb um die immer anspruchsvollen Kunden mitzuhalten.

Gleichzeitig besitzen sie mit einer geeigneten HCI eine Infrastruktur, die ihnen wegen ihrer Durchgängigkeit und der Unterstützung vielfältiger Technologieoptionen von Bare Metal über virtuelle Maschinen bis Public Cloud und Container tatsächlich die Wahl lässt, wo und in welcher Form sie im gegebenen Moment eine Applikation am besten laufen lassen – wenn die Migration einfach genug ist, kann man dies ja jederzeit ändern.